L’impact, un concept complexe. Le résultat du suivi et de l’évaluation est clairement et directement appréciable lorsqu’il concerne des aspects opérationnels : activités et résultats réalisés, bénéficiaires atteints, conséquences immédiates et visibles d’un projet qui vient de s’achever. Ces données, qui sont principalement obtenues par le biais d’activités de suivi, sont également les plus importantes pour les responsables de la mise en œuvre des projets, qui en sont directement comptables.

Il est en revanche plus complexe de répondre à des questions plus larges et plus stratégiques, typiques du travail d’évaluation : quel a été (et quel sera) l’impact du projet ? Le projet a-t-il atteint son but ultime, c’est-à-dire son objectif global ? A-t-il produit les effets et les changements escomptés lors de son élaboration ?

Pour répondre à ces questions avec des preuves objectives, il est nécessaire de collecter des données après la fin du projet et d’utiliser des ressources qui peuvent aller au-delà de ce qui est mis à disposition dans le cadre d’un seul projet européen.

De plus, l’impact est un concept complexe d’un point de vue conceptuel et statistique-mathématique car de nombreux facteurs y contribuent : il n’est pas facile d' »isoler » la contribution du projet d’une pluralité d’autres facteurs concomitants. Par exemple : dans quelle mesure les effets d’un projet de réduction de la pauvreté sur une communauté sont-ils appréciables et comment peuvent-ils être isolés d’une pluralité d’autres facteurs (positifs ou négatifs) tels que les effets de la situation économique, les politiques industrielles, d’autres projets parallèles et l’initiative des membres de la communauté ?

La mesure de l’impact reste cependant une préoccupation légitime : l’impact fait partie intégrante de la logique du projet et de son cadre de suivi et d’évaluation ; c’est le point de départ et d’arrivée de toute personne qui met en œuvre ou finance un projet ; c’est ce qui définit au sens le plus large le succès réel du projet.

Encore une fois, la discussion qui suit ne prétend pas à la rigueur scientifique ou à l’exhaustivité, mais vise à traduire le concept d' »impact » en quelques idées qui peuvent être « à la portée » des responsables de la mise en œuvre des projets européens.

L’impact en tant qu’analyse contrefactuelle. L’analyse contrefactuelle définit l’impact comme la différence entre les données collectées à la fin d’une intervention (données « factuelles ») et les données collectées dans une situation sans intervention (données « contrefactuelles »). Il s’agit de l’approche la plus « scientifique » de l’évaluation d’impact : elle est utilisée dans la recherche médicale pour comparer des groupes de « traitement » à des séries chronologiques ou à des groupes de contrôle.

Cette approche est difficilement utilisable dans le domaine social, car elle présuppose.. :

- L’existence d’indicateurs qui sont vérifiables sans ambiguïté à l’aide d’outils analytiques et qui ont un lien également sans ambiguïté et à long terme avec la dimension qu’ils sont censés mesurer ;

- Ou encore, la possibilité d’identifier un « groupe de contrôle » dont les caractéristiques et la dynamique sont tout à fait comparables à celles du groupe cible du projet.

Ce ne sont pas des conditions faciles pour de nombreux projets impliquant des aspects « humains » et sociaux, où la corrélation entre les données et le phénomène mesuré peut être plus ou moins forte, mais n’est guère univoque et dépend de l’intervention de plusieurs facteurs (en particulier compte tenu de la petite échelle d’un projet normal) ; et où les situations des groupes et des communautés sont très variées, complexes et difficiles à comparer avec les ressources limitées d’un projet normal.

Malgré ses limites opérationnelles dans le contexte des projets européens, l’analyse contrefactuelle reste une « référence idéale » utile pour mesurer l’impact. Elle peut être réalisée avec trois modifications :

- Celle qui s’appelle « Conception avant-après ».qui estime l’impact à partir des écarts entre de longues séries de données (et les projections qui en résultent) et ce qui est observé après la réalisation du projet. Cette modalité nécessite une durée et une portée qui sont difficiles à faire correspondre aux données et aux réalisations d’un projet ;

- Celle qui s’appelle « Conception du groupe de contrôle ».qui estime l’impact en analysant la différence entre le groupe de bénéficiaires du projet et un « groupe de contrôle » ayant les mêmes caractéristiques. Ce mode implique l’identification (et l’analyse) d’un groupe de contrôle « autre » que les activités du projet ;

- Celle qui s’appelle Différence dans les différences ».qui combine les deux modes précédents et analyse la double variation d’une variable : dans le temps (avant, après, ex-post’ ) et entre sujets (bénéficiaires et non bénéficiaires).

Impact en tant que changement de tendance. L’analyse contrefactuelle peut être utilisée sous une forme atténuée, en adoptant une approche moins rigoureuse dans le traitement des données du projet et des tendances de référence, avec un degré de complexité proportionnel aux ambitions du projet et aux ressources disponibles. En revanche, si le groupe des « sujets traités » (c’est-à-dire les bénéficiaires du projet) ne concerne (comme c’est souvent le cas) que quelques dizaines de personnes, une étude d’impact contrefactuelle sérieuse perd de son sens et de sa pertinence scientifique.

Le « changement de trajectoire » dans la tendance estimée aura donc une valeur narrative et indicative. Il peut toutefois être utile de formuler quelques suggestions à la fin d’un projet, en combinaison avec les éléments plus substantiels d’un rapport, concernant des aspects plus facilement et objectivement vérifiables (activités et résultats réalisés, bénéficiaires atteints, données de suivi sur les bénéficiaires). Pour rendre l’estimation de l’impact plus réaliste et véridique, il est conseillé de.. :

- Circonscrire l’étendue du phénomène à mesurer à ce à quoi le projet a contribué le plus fortement et le plus directement (augmentant ainsi le niveau de corrélation entre l’indicateur et l’objectif mesuré) ;

- Comparer l’évolution enregistrée par les données du projet à des points de référence aussi « proches » que possible de la population cible du projet (situation « quasi-contrefactuelle ») ;

- Si possible, combinez des références comparatives différentes et complémentaires, en « triangulant » différentes données et différents points de vue afin d’accroître la fiabilité des résultats ;

- Incluez dans l’analyse, si possible, plusieurs moments de mesure (pour établir une tendance), y compris des mesures de « suivi » (par exemple, un, deux ou trois ans après la fin du projet) ;

- Accompagnez l’analyse d’une évaluation des facteurs (positifs ou négatifs) qui ont pu influencer les données et les « tendances » du projet ainsi que les références utilisées.

Par exemple, dans le cadre d’un projet consacré au placement des jeunes de 15 à 24 ans résidant dans une zone urbaine en proie à des problèmes sociaux, on peut comparer l’évolution des données relatives à l’emploi des jeunes de 15 à 24 ans enregistrées :

- Du projet sur ses bénéficiaires (données de base vs. données finales : données « factuelles »).

- Dans la zone d’intervention du projet (ou dans une autre zone urbaine en proie à des problèmes sociaux), au cours de la même période (données « quasi-contrefactuelles »).

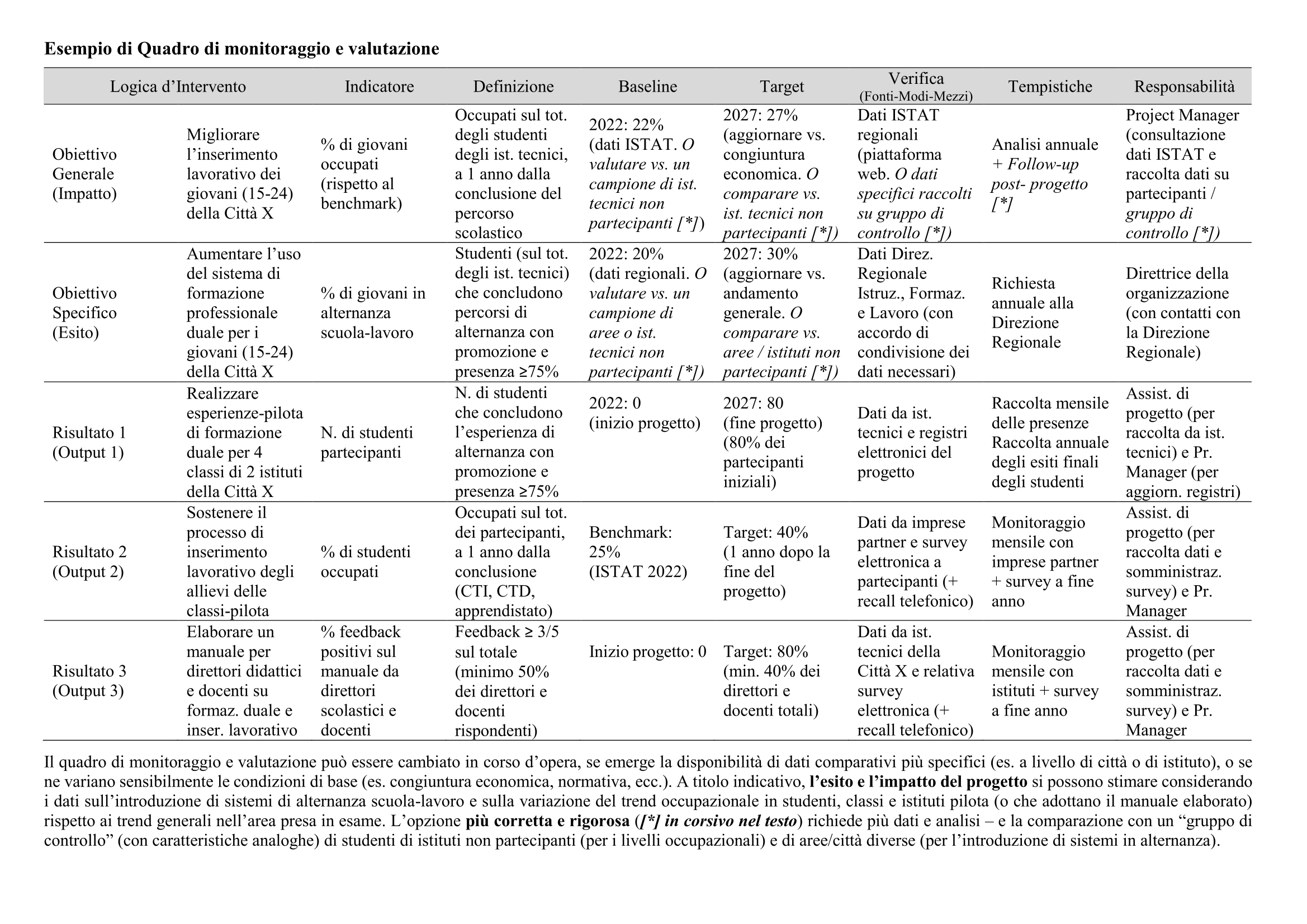

Un exemple plus détaillé et plus spécifique est donné à la fin de l’exemple de cadre de suivi et d’évaluation.

Le choix du critère de référence (ou l’utilisation simultanée de plusieurs critères) peut varier en fonction de la disponibilité des données. Les différences entre les « données factuelles » et les « données quasi-contrefactuelles » peuvent être analysées (et éventuellement pondérées ou corrigées) à la lumière d’autres facteurs et variables susceptibles d’avoir affecté les deux populations de référence :

- Facteurs positifs – par exemple, les résultats positifs obtenus grâce à des initiatives parallèles dans le domaine (par exemple, cours de formation professionnelle, soutien à l’apprentissage, outils permettant de « faire correspondre » l’offre et la demande de main-d’œuvre…).

- Facteurs négatifs – par exemple, les difficultés économiques des entreprises de la région ou l’aggravation des conditions favorables (par exemple, la diminution des ressources allouées par les gouvernements à l’éducation ou à l’assistance sociale).

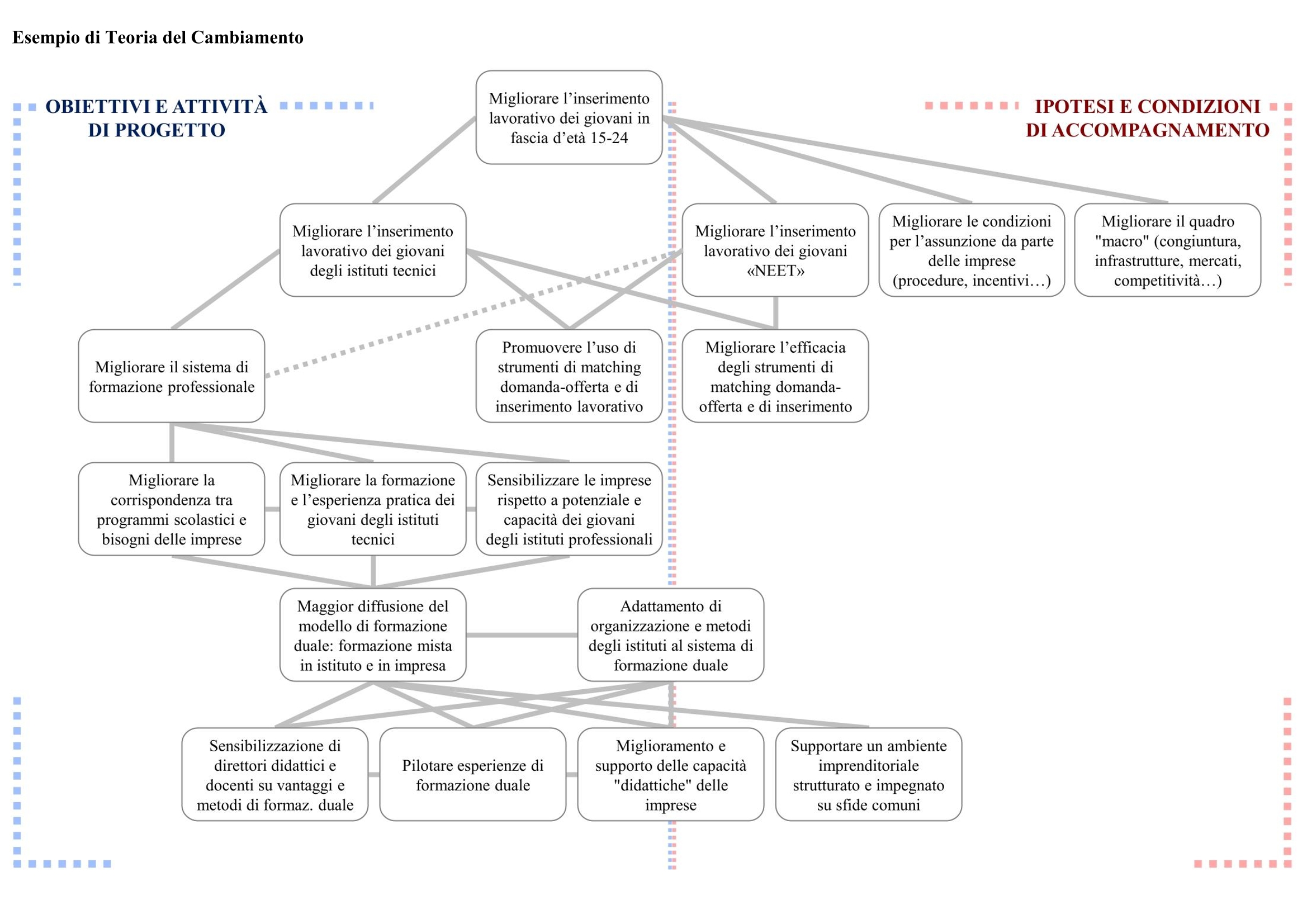

La théorie du changement peut contribuer à cette activité de pondération, car elle fournit une « cartographie » de toutes les conditions nécessaires à la réalisation du changement souhaité.

Lorsque cela est possible et que les ressources sont disponibles, il est possible de lancer des activités de collecte de données dans le cadre du projet, soit sur le groupe de bénéficiaires (par exemple, les jeunes de 15 à 24 ans de certains instituts techniques), soit sur des groupes de contrôle aussi similaires que possible (par exemple, les jeunes de 15 à 24 ans des mêmes instituts, répartis de manière similaire en termes d’âge, de classe, de fréquentation scolaire moyenne, de sexe, de revenu familial ou les jeunes de 15 à 24 ans d’autres instituts techniques du même type et de la même taille, situés dans des quartiers présentant des conditions socio-économiques similaires).

L’impact en tant que « récits » de changement. Ce qui a été illustré jusqu’à présent suit un schéma logique et structuré, plus ou moins quantitatif, basé sur le concept de « mesure » du changement obtenu par rapport à ce que le projet propose.

Dans certains projets, ce schéma peut être complexe ou insuffisant pour illustrer correctement et complètement les changements qualitatifs, les phénomènes inattendus et les effets non définis dans les mesures initiales. C’est pourquoi il existe des méthodes plus larges, qualitatives ou non contraignantes pour mesurer l’impact par rapport à des « objectifs » initiaux (par ex. l’évaluation « sans objectif).

Là encore, un traitement complet, exhaustif et rigoureux du sujet dépasse les ambitions de ce guide. Cependant, il est important d’attirer l’attention sur l’importance des aspects qualitatifs et moins structurés dans la mesure de l’impact d’un projet.

En termes opérationnels, cela signifie qu’il faut poser les questions suivantes: comment la vie des bénéficiaires (ou des organisations bénéficiaires) a-t-elle changé à la suite du projet ? Quel rôle le projet a-t-il joué dans leur évolution, leur « histoire » et leur expérience individuelle ? Selon la perception des bénéficiaires (ou des organisations bénéficiaires), quelle aurait été leur vie et leur histoire sans l’intervention du projet ? Ces petites « histoires » individuelles sont-elles capables de produire à leur tour de nouvelles « histoires de changement », petites et évocatrices ? À travers les « histoires » et les points de vue individuels, est-il possible de tracer une ligne qui identifie les paramètres de réussite et les faiblesses du projet ?

Les « histoires » peuvent être recueillies et évaluées au moyen de diverses méthodes d’analyse qualitative, déjà mentionnées dans les sections précédentes : entretiens et groupes de discussion ; études de cas et enquêtes narratives ; méthodes plus spécifiques, telles que le « changement le plus significatif » et les systèmes d’analyse et de représentation graphique des tendances et des changements qualitatifs. Ce type d’analyse adopte une approche empirique basée sur l‘ »induction« , c’est-à-dire la formulation de conclusions générales à partir de cas particuliers. Elle ne doit pas être considérée comme un « plan B » par rapport à d’autres méthodologies, car elle peut être en mesure de saisir des éléments différents, plus profonds ou au moins complémentaires par rapport à des systèmes d’analyse plus structurés.

Une analyse au moyen d' »histoires » de différents types permet également de développer un matériel de communication et de diffusion intéressant et utilisable par un large public de spécialistes (en raison de la profondeur de l’analyse), par les partenaires et les parties prenantes (qui peuvent à leur tour se l’approprier et le diffuser) et par le public plus large des profanes.

Ces aspects sont pertinents et appréciés dans les projets européens. Les rapports et la communication sont des aspects interdépendants qui répondent à un objectif commun de responsabilité et de transparence (responsabilité) à l’égard des institutions, des citoyens et de leurs communautés.

Approfondir les concepts et les approches de l’impact. Pour ceux qui souhaitent aborder les méthodologies de mesure et de gestion de l’impact de manière plus approfondie et selon des perspectives alternatives et complémentaires, nous recommandons :

1. L’IPSEE (Inventaire des problèmes, des solutions et des preuves d’effets), une plateforme dédiée maintenue par l’ASVAPP, l’Association pour le développement de l’évaluation et de l’analyse des politiques publiques. Elle propose un examen des problèmes que les politiques publiques devraient traiter, des solutions adoptées, des preuves empiriques existantes sur leurs effets, accompagné d’un glossaire de l’ impact et d’une vue d’ensemble des méthodes utilisées ;

2. Unlarge éventail de guides et d’outils produits par des organisations spécialisées dans le domaine de l’investissement d’impact, auxquels nous avons consacré une section spéciale. L’investissement d’impact se caractérise par une mobilisation méthodique et consciente des ressources pour obtenir un impact mesurable dans des domaines où il fait défaut (principes d’intentionnalité, de mesurabilité et d’additionnalité) ;

3. Un guide développé dans le cadre de CIVITAS, une initiative de l’Union européenne dédiée à la mobilité urbaine. Bien qu’il contienne des exemples dédiés au secteur spécifique, il fournit un traitement très clair, complet et général du sujet de l’évaluation des projets et des programmes.

4. Un manuel convivial d’ évaluation de projet élaboré aux États-Unis (agence gouvernementale National Science Foundation), qui présente une approche systématique, complète et scientifique du sujet de l’évaluation de projet.