Wirkung, ein komplexes Konzept. Das Ergebnis von Monitoring und Evaluierung ist klar und direkt spürbar, wenn es sich um operative Aspekte handelt: durchgeführte Aktivitäten und Outputs, erreichte Begünstigte, unmittelbare und sichtbare Folgen eines gerade abgeschlossenen Projekts. Diese Daten, die hauptsächlich durch Monitoring-Aktivitäten gewonnen werden, sind auch die wichtigsten für die Projektdurchführenden, die direkt für sie verantwortlich sind.

Die Beantwortung umfassenderer und strategischerer Fragen, wie sie für die Evaluierungsarbeit typisch sind, ist dagegen komplexer: Welche Auswirkungen hatte das Projekt (und welche werden es haben)? Hat das Projekt sein Endziel, d.h. sein Gesamtziel, erreicht? Hat es die Auswirkungen und Veränderungen bewirkt, die es bei seiner Entwicklung beabsichtigte?

Um diese Fragen mit objektiven Beweisen zu beantworten, ist es notwendig, nach dem Ende des Projekts Daten zu sammeln und Ressourcen zu nutzen, die über das hinausgehen, was im Rahmen eines einzelnen europäischen Projekts zur Verfügung gestellt wird.

Darüber hinaus ist der Begriff der Wirkung aus konzeptioneller und statistisch-mathematischer Sicht komplex, da viele Faktoren dazu beitragen: Es ist nicht einfach, den Beitrag des Projekts von einer Vielzahl anderer begleitender Faktoren zu „isolieren“. Zum Beispiel: Wie spürbar sind die Auswirkungen eines Armutsbekämpfungsprojekts auf eine Gemeinde, und wie lassen sie sich von einer Vielzahl anderer (positiver oder negativer) Faktoren wie den Auswirkungen der Wirtschaftslage, der Industriepolitik, anderer paralleler Projekte und der Initiative von Gemeindemitgliedern trennen?

Die Messung der Auswirkungen bleibt jedoch ein berechtigtes Anliegen: Die Auswirkungen sind ein integraler Bestandteil der Projektbegründung und des Überwachungs- und Bewertungsrahmens; sie sind der Ausgangs- und Endpunkt für jeden, der ein Projekt durchführt oder finanziert; sie definieren im weitesten Sinne den tatsächlichen Erfolg des Projekts.

Auch die folgende Diskussion erhebt keinen Anspruch auf wissenschaftliche Strenge oder Vollständigkeit, sondern zielt darauf ab, das Konzept der ‚Wirkung‘ in einige Einsichten zu übersetzen, die für europäische Projektdurchführer ‚greifbar‘ sein könnten.

Auswirkungen als kontrafaktische Analyse. Die kontrafaktische Analyse definiert die Wirkung als den Unterschied zwischen den Daten, die am Ende einer Intervention erhoben wurden („faktische“ Daten) und den Daten, die in einer Situation ohne Intervention erhoben wurden („kontrafaktische“ Daten). Dies ist der „wissenschaftlichste“ Ansatz zur Folgenabschätzung: Er wird in der medizinischen Forschung verwendet, um „Behandlungsgruppen“ mit Zeitreihen oder Kontrollgruppen zu vergleichen.

Dieser Ansatz ist im sozialen Bereich nur schwer anwendbar, da er voraussetzt:

- Das Vorhandensein von Indikatoren, die mit analytischen Instrumenten eindeutig überprüfbar sind und eine ebenso eindeutige und langfristige Verbindung zu der Dimension haben, die sie messen sollen;

- Oder die Möglichkeit, eine „Kontrollgruppe“ zu identifizieren, deren Merkmale und Dynamik mit denen der Zielgruppe des Projekts vollständig vergleichbar sind.

Dies sind keine einfachen Bedingungen für viele Projekte, bei denen es um „menschliche“ und soziale Aspekte geht, bei denen die Korrelation zwischen Daten und gemessenen Phänomenen zwar mehr oder weniger stark sein mag, aber kaum eindeutig ist und vom Zusammenspiel mehrerer Faktoren abhängt (insbesondere angesichts des geringen Umfangs eines normalen Projekts); und bei denen die Situationen von Gruppen und Gemeinschaften sehr vielfältig und komplex sind und sich nur schwer mit den begrenzten Ressourcen eines normalen Projekts vergleichen lassen.

Trotz ihrer operativen Einschränkungen im Zusammenhang mit europäischen Projekten bleibt die kontrafaktische Analyse eine nützliche „ideale Referenz“ für die Messung der Auswirkungen. Sie kann mit drei Modifikationen durchgeführt werden:

- Das sogenannte „Prä-Post-Design“.bei dem die Auswirkungen anhand der Diskrepanzen zwischen langen Zeitreihen von Daten (und den daraus resultierenden Projektionen) und dem, was nach der Projektrealisierung beobachtet wird, geschätzt werden. Diese Modalität erfordert eine Zeitspanne und einen Umfang, die nur schwer mit den Daten und der Realisierung eines Projekts in Einklang zu bringen sind;

- Das sogenannte „Kontrollgruppen-Design“.bei dem die Auswirkungen geschätzt werden, indem der Unterschied zwischen der Gruppe der Projektbegünstigten und einer „Kontrollgruppe“ mit denselben Merkmalen analysiert wird. Dieser Modus impliziert die Identifizierung (und Analyse) einer Kontrollgruppe, die „anders“ ist als die Projektaktivitäten;

- Die sogenannte ‚Differenz in Unterschieden‘.die die beiden vorherigen Modi kombiniert und die doppelte Variation einer Variablen analysiert: im Laufe der Zeit (vorher, nachher, ex-post) und zwischen Subjekten (Empfängern und Nicht-Empfängern).

Auswirkungen als Veränderung eines Trends. Die kontrafaktische Analyse kann in abgeschwächter Form verwendet werden, indem ein weniger rigoroser Ansatz im Umgang mit Projektdaten und Referenztrends gewählt wird, wobei der Grad der Komplexität proportional zu den Ambitionen des Projekts und den verfügbaren Ressourcen ist. Andererseits verliert eine seriöse kontrafaktische Folgenabschätzung ihren Sinn und ihre wissenschaftliche Relevanz, wenn die Gruppe der „behandelten Subjekte“ (d.h. die Begünstigten des Projekts) nur ein paar Dutzend Menschen betrifft (wie es oft der Fall ist).

Die „Veränderung der Flugbahn“ im geschätzten Trend hat daher einen erzählerischen und indikativen Wert. Es kann jedoch sinnvoll sein, zum Abschluss eines Projekts einige Vorschläge zu machen, die sich auf leichter und objektiv überprüfbare Aspekte beziehen (durchgeführte Aktivitäten und Outputs, erreichte Begünstigte, Follow-up-Daten zu den Begünstigten), und zwar in Kombination mit den substanzielleren Elementen eines Berichts. Um die Einschätzung der Auswirkungen realistischer und wahrheitsgetreuer zu gestalten, ist es ratsam:

- Beschränken Sie den Umfang des zu messenden Phänomens auf das, wozu das Projekt am stärksten und direktesten beigetragen hat (und erhöhen Sie so den Grad der Korrelation zwischen dem Indikator und dem zu messenden Ziel);

- Vergleich der von den Projektdaten aufgezeichneten Entwicklung mit Referenzpunkten, die der Zielpopulation des Projekts so „nahe“ wie möglich kommen („quasi-kontrafaktische“ Situation);

- Kombinieren Sie, wenn möglich, verschiedene und sich ergänzende vergleichende Referenzen, indem Sie verschiedene Daten und Standpunkte „triangulieren“, um die Zuverlässigkeit der Ergebnisse zu erhöhen;

- Beziehen Sie, wenn möglich, mehrere Messzeitpunkte in die Analyse ein (um einen Trend zu ermitteln), einschließlich „Follow-up“-Messungen (z. B. ein, zwei oder drei Jahre nach Ende des Projekts);

- Begleiten Sie die Analyse mit einer Bewertung der (positiven oder negativen) Faktoren, die die Daten und „Trends“ des Projekts beeinflusst haben könnten, und den verwendeten Referenzen.

Bei einem Projekt zur Arbeitsvermittlung für junge Menschen im Alter von 15-24 Jahren, die in einem städtischen Gebiet mit sozialen Problemen wohnen, können Sie beispielsweise die Veränderungen bei den erfassten Beschäftigungsdaten junger Menschen im Alter von 15-24 Jahren vergleichen:

- Vom Projekt zu seinen Nutznießern (Ausgangsdaten vs. Enddaten: „faktische“ Daten).

- Im Projektgebiet (oder in einem anderen städtischen Gebiet mit sozialen Problemen), während des gleichen Zeitraums (eine „quasi-kontrafaktische“ Zahl).

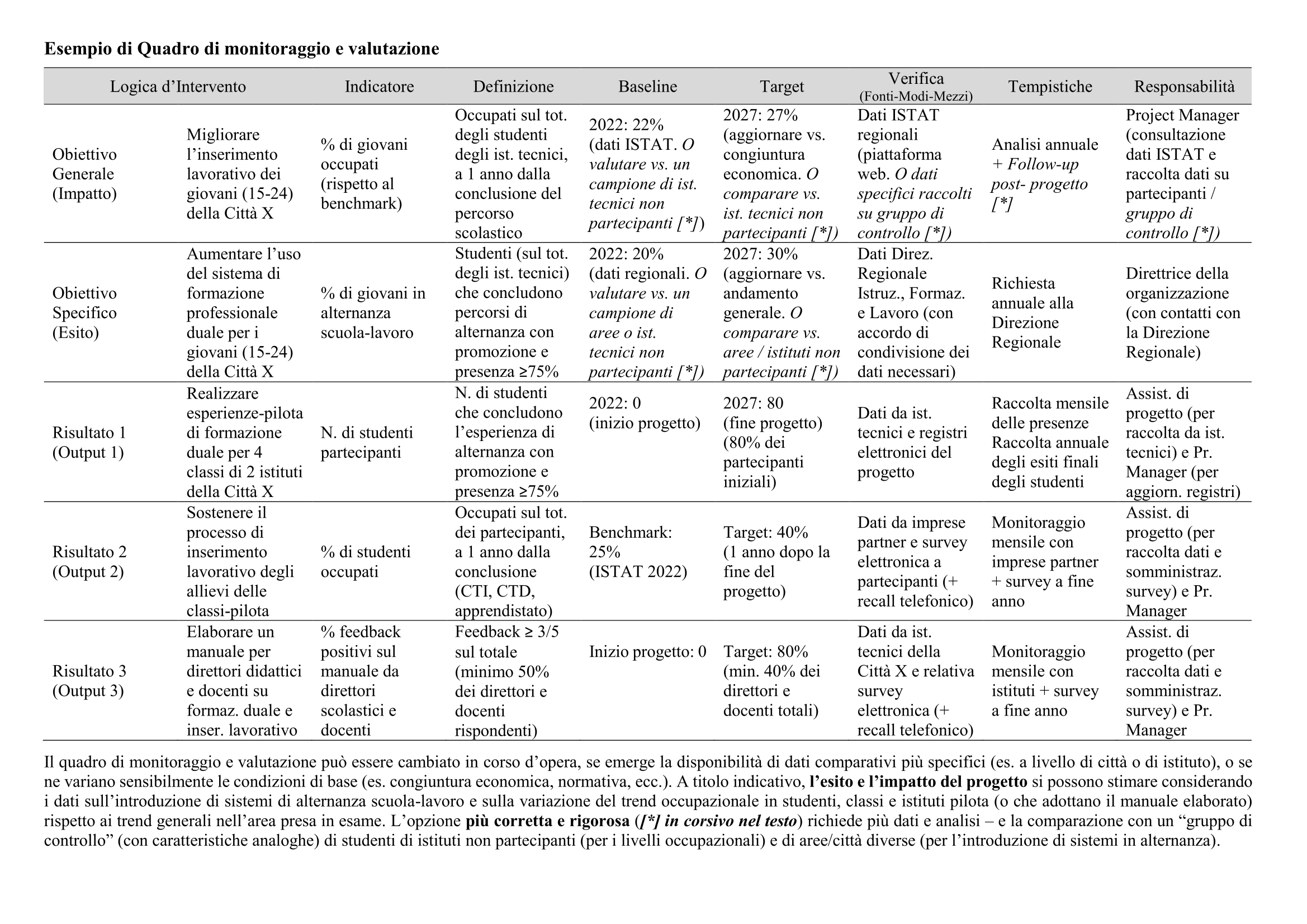

Ein ausführlicheres und spezifischeres Beispiel finden Sie am Ende desBeispiels für den Überwachungs- und Bewertungsrahmen.

Die Wahl des Benchmarks (oder die gleichzeitige Verwendung mehrerer Benchmarks) kann je nach Verfügbarkeit von Daten variieren. Unterschiede zwischen „faktischen Daten“ und „quasi-kontrafaktischen Daten“ können unter Berücksichtigung anderer Faktoren und Variablen, die die beiden Referenzpopulationen beeinflusst haben könnten, analysiert (und möglicherweise gewichtet oder korrigiert) werden:

- Positive Faktoren – z.B. positive Ergebnisse, die durch parallele Initiativen in diesem Bereich erzielt wurden (z.B. berufsbildende Kurse, Unterstützung für Lehrstellen, Instrumente zur Abstimmung von Arbeitsangebot und -nachfrage…).

- Negative Faktoren – z.B. wirtschaftliche Schwierigkeiten von Unternehmen in der Region oder sich verschlechternde Rahmenbedingungen (z.B. Rückgang der von der Regierung für Bildung oder Sozialhilfe bereitgestellten Mittel).

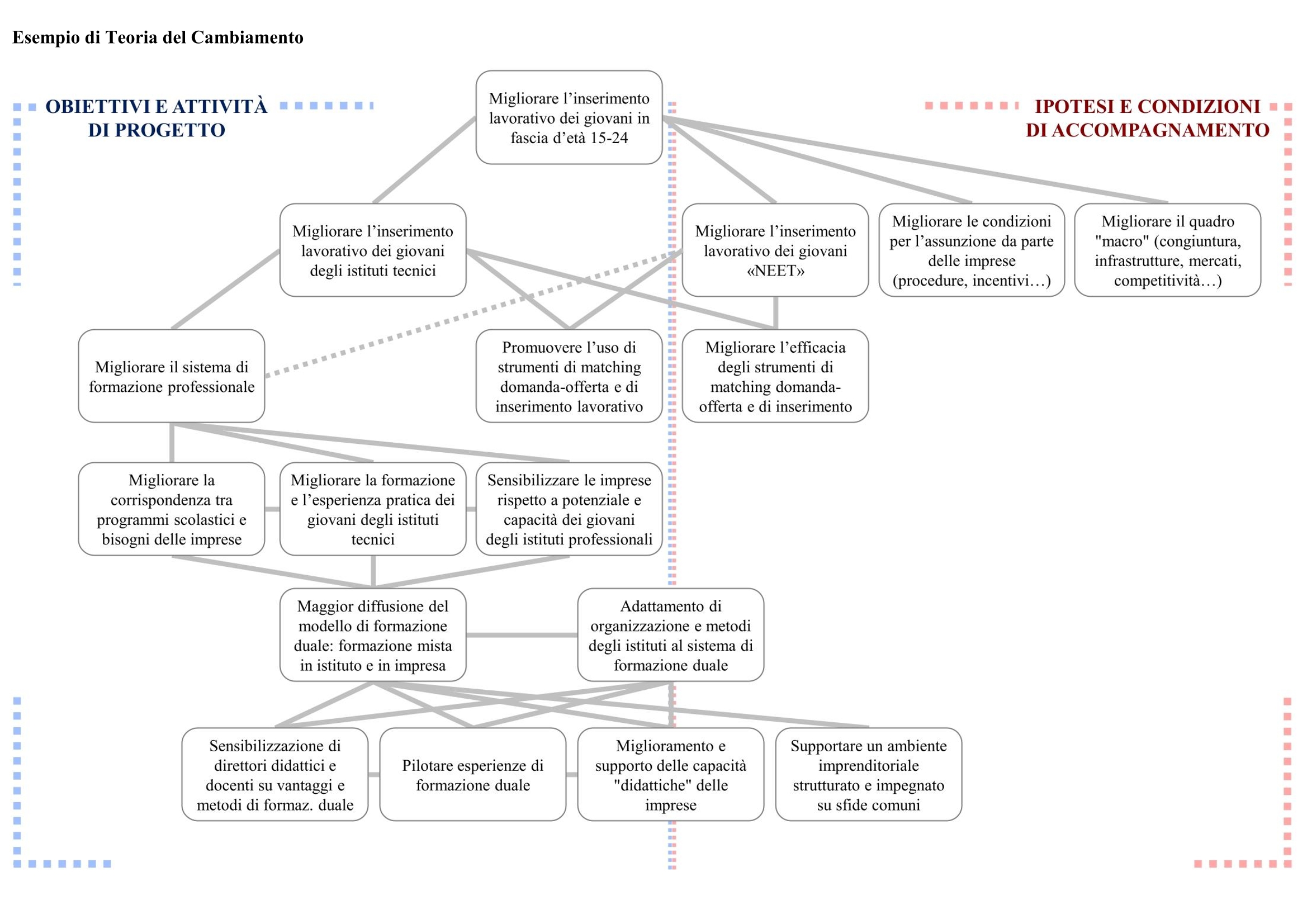

Die Theorie der Veränderung kann bei dieser Abwägung helfen, da sie eine „Kartierung“ aller Bedingungen liefert, die notwendig sind, um eine gewünschte Veränderung herbeizuführen.

Wenn dies möglich ist und die entsprechenden Mittel zur Verfügung stehen, kann im Rahmen des Projekts mit der Datenerhebung begonnen werden, und zwar entweder bei der Gruppe der Begünstigten (z. B. Jugendliche zwischen 15 und 24 Jahren aus bestimmten technischen Instituten) oder bei möglichst ähnlichen Kontrollgruppen (z. B. Jugendliche zwischen 15 und 24 Jahren aus denselben Instituten, die in Bezug auf Alter, Klasse, durchschnittlichen Schulbesuch, Geschlecht und Familieneinkommen ähnlich verteilt sind, oder Jugendliche zwischen 15 und 24 Jahren aus anderen technischen Instituten desselben Typs und derselben Größe, die in Vierteln mit ähnlichen sozioökonomischen Bedingungen liegen).

Nicht-experimentelle Methoden der Folgenabschätzung. Es gibt verschiedene Methoden, die nicht streng quantitativ sind, um die Auswirkungen eines Projekts anhand seiner Interventionslogik oder seiner Theorie der Veränderung zu messen. Dabei handelt es sich um nicht-experimentelle Methoden, die daher weniger „wissenschaftlich“ sind als kontrafaktische Methoden, die aber darauf abzielen, den Prozess der Zuordnung von Veränderungen oder beobachteten Ergebnissen zu einem bestimmten Projekt oder einer Intervention zu formalisieren. Wir erwähnen sie im Besonderen:

- DieBeitragsanalyse. Diese Methodik beginnt mit einer begründeten und plausiblen Kausaltheorie darüber, wie eine Veränderung zustande kommen soll (Interventionslogik oder Theorie der Veränderung). Sie konzentriert sich dann auf das Sammeln von Beweisen, die diese Theorie bestätigen: Sie sucht nach anderen Faktoren, die zu den beobachteten Ergebnissen beigetragen haben könnten, und identifiziert und schließt (wenn möglich) alternative oder ergänzende Erklärungen aus, die zu diesen Ergebnissen geführt haben könnten. Zu diesem Zweck werden verschiedene Perspektiven (z. B. Kontext, andere Interventionen, Erzählungen der Akteure, Feedback der Begünstigten) einbezogen, um verschiedene Faktoren oder „Kausalpfade“ aufzuzeigen, die zu den Ergebnissen geführt oder beigetragen haben könnten;

- Die Global Elimination Methodology (GEM) basiert auf der systematischen Identifizierung möglicher alternativer Erklärungen, die zu den beobachteten Ergebnissen geführt haben könnten, indem für jedes interessierende Ergebnis eine Liste von Ursachen und ihren miteinander verknüpften „modus operandi“ erstellt wird. Anschließend wird ermittelt, welche der Ursachen eingetreten sind und welche der „modus operandi“ beobachtet wurden. Ursachen, bei denen der entsprechende „modus operandi“ nicht beobachtet wurde, werden verworfen, so dass nur diejenigen kausalen Erklärungen übrig bleiben, die einen echten Kausalzusammenhang aufweisen. Auf dieser Grundlage kann die tatsächliche Wirksamkeit der Intervention genauer kontextualisiert und bewertet werden;

- Die realistische Bewertung geht von der Überlegung aus, dass die Wirksamkeit einer Intervention nicht nur von den Ursache-Wirkungs-Beziehungen dessen abhängt, was ein Projekt oder eine Intervention bewirkt, sondern von einer Vielzahl von Mechanismen, die mit dem Kontext, der Gruppe von Akteuren und einer Gemeinschaft, ihren historischen, kulturellen, wirtschaftlichen, menschlichen und sozialen Interaktionen und Dynamiken zusammenhängen. In verschiedenen Kontexten und in verschiedenen Gemeinschaften wird eine Intervention unterschiedliche Ergebnisse und Wirksamkeit haben. Die Evaluierung (die sich auf quantitative und qualitative Quellen stützt) versucht daher, eine Reihe hypothetischer „Mini-Theorien des Wandels“ zu entwerfen, die in der Lage sind, die verschiedenen Dynamiken zu erfassen und die Intervention und ihre Wirksamkeit in diesem Kontext zu kontextualisieren;

- Die Qualitative Comparative Analysis (QCA) vergleicht verschiedene Fälle (Konfigurationen verschiedener möglicher kausaler Bedingungen), die jedoch ein ähnliches Ergebnis hervorgebracht haben. Sie analysiert daher Cluster von Faktoren, die in verschiedenen Fällen vorhanden sind, aber zu den gewünschten Ergebnissen und Auswirkungen geführt haben, um den Grad der Relevanz jeder Bedingung für das Erreichen der gewünschten Auswirkungen zu bestimmen und die einfachste Gruppe von Bedingungen zu ermitteln, die alle beobachteten Ergebnisse sowie deren Fehlen erklären kann;

- Die Prozessverfolgung ist eine Methode zur Untersuchung und Prüfung eines bestimmten kausalen Zusammenhangs, um zu beurteilen, ob die Beweise ausreichen, um eine Schlussfolgerung über die Ursache zu ziehen. Sie wendet vier Arten von Tests mit zunehmender ‚Stärke‘ an: der ‚Strohhalm im Wind‘-Test, der es ermöglicht, zu bestimmen, ob es Bedingungen gibt, die einen kausalen Zusammenhang von vornherein ausschließen; der ‚Kreis‘-Test, der es ermöglicht, einen kausalen Zusammenhang auszuschließen, wenn die analysierte Bedingung vorliegt, aber das erwartete Ergebnis nicht vorhanden ist; der ’smoking gun‘-Test, der im Gegenteil das gemeinsame Vorhandensein (und tendenziell den kausalen Zusammenhang) der analysierten Bedingung und des erwarteten Ergebnisses bestätigt; der ‚double definitive‘-Test erlaubt es (in sehr seltenen Fällen), die Existenz anderer kausaler Zusammenhänge zusätzlich zu dem identifizierten auszuschließen.

Auswirkungen als ‚Geschichten‘ des Wandels. Was bisher dargestellt wurde, folgt einem logischen und strukturierten Schema, das mehr oder weniger quantitativ ist und auf dem Konzept der „Messung“ der erzielten Veränderungen in Bezug auf und unter Verwendung von mehr oder weniger ausgefeilten statistischen Techniken basiert (je nach den Ambitionen der „Wissenschaftlichkeit“ des durchgeführten Evaluierungsprozesses).

Bei einigen Projekten kann dieses Schema komplex oder unzureichend sein, um qualitative Veränderungen, unerwartete Phänomene und Effekte, die in den ursprünglichen Metriken nicht definiert wurden, korrekt und vollständig darzustellen. Aus diesem Grund gibt es breiter angelegte, qualitative oder uneingeschränkte Methoden zur Messung der Auswirkungen gegenüber den anfänglichen ‚Zielen‘ (z.B. zielfreie‘ Bewertung).

Auch hier liegt eine umfassende, erschöpfende und strenge Behandlung des Themas jenseits der Ambitionen dieses Leitfadens. Es ist jedoch wichtig, auf die Bedeutung der qualitativen und weniger strukturierten Aspekte bei der Messung der Auswirkungen eines Projekts hinzuweisen.

Auf operativer Ebene bedeutet dies, die folgenden Fragen zu stellen: Wie hat sich das Leben der Begünstigten (oder der begünstigten Organisationen) durch das Projekt verändert? Welche Rolle hat das Projekt für ihre Entwicklung, ihre „Geschichte“ und ihre individuellen Erfahrungen gespielt? Wie hätten die Begünstigten (oder die begünstigten Organisationen) ihr Leben und ihre Geschichte ohne die Projektintervention erlebt? Sind diese kleinen individuellen „Geschichten“ in der Lage, ihrerseits neue kleine und eindrucksvolle „Geschichten des Wandels“ hervorzubringen? Ist es möglich, anhand der individuellen „Geschichten“ und Sichtweisen eine Linie zu ziehen, die die Erfolgsparameter und Schwächen des Projekts aufzeigt?

Geschichten“ können durch verschiedene Methoden der qualitativen Analyse gesammelt und ausgewertet werden, die bereits in den vorangegangenen Abschnitten erwähnt wurden: Interviews und Fokusgruppen, Fallstudien und narrative Umfragen, spezifischere Methoden wie die„bedeutendste Veränderung„ und Systeme zur Analyse und grafischen Darstellung von Trends und qualitativen Veränderungen.

Diese Art der Analyse verfolgt einen empirischen Ansatz, der auf„Induktion“ beruht, d.h. auf der Formulierung allgemeiner Schlussfolgerungen aus bestimmten Fällen. Sie sollte nicht als ‚Plan B‘ im Vergleich zu anderen Methoden betrachtet werden, da sie im Vergleich zu stärker strukturierten Analysesystemen möglicherweise andere, tiefere oder zumindest ergänzende Elemente erfassen kann.

Ein weiterer weit verbreiteter qualitativer Bewertungsansatz ist dasOutcome Mappingdas die Auswirkungen eines Projekts oder einer Intervention abschätzt, indem es die Veränderungen im Verhalten, in den Beziehungen, Aktivitäten und Handlungen von Menschen, Gruppen und Organisationen analysiert, mit denen direkt gearbeitet wurde. Er basiert auf der Annahme, dass jeglicher sozialer Wandel letztlich von Veränderungen im menschlichen Verhalten abhängt und dass die Nachhaltigkeit jeglichen Wandels von den Beziehungen zwischen den Menschen abhängt. Aus dieser Philosophie ergibt sich der Gegenstand des entsprechenden Evaluierungsmonitoringsystems: 1) die Vision, zu der die Intervention beitragen will, und (vor allem) die Veränderungen im Verhalten, im Handeln und in den Beziehungen, die erreicht werden sollen; 2) die ‚Grenzpartner‘ der Intervention, d.h. die Personen, Gruppen und Organisationen, mit denen das Programm direkt interagiert und auf die es direkte Einflussmöglichkeiten hat. Die sich daraus ergebende Analyse ist qualitativer Natur und konzentriert sich auf die Beobachtung (und manchmal Selbsteinschätzung) der Verhaltensänderung derjenigen, die mit dem Projekt arbeiten. Obwohl sie weniger streng ist, kann sie daher einfacher und besser anwendbar sein als andere Ansätze.

Eine Analyse anhand von ‚Geschichten des Wandels‘ verschiedener Art ermöglicht es, Kommunikations- und Verbreitungsmaterial zu entwickeln, das für ein breites Fachpublikum (aufgrund seiner Analysetiefe), für Partner und Interessengruppen (die es sich wiederum zu eigen machen und verbreiten können) und für die breite Laienöffentlichkeit interessant und nutzbar ist.

Diese Aspekte sind relevant und werden in europäischen Projekten geschätzt. Berichterstattung und Kommunikation sind miteinander verknüpfte Aspekte, die dem gemeinsamen Ziel der Rechenschaftspflicht und Transparenz entsprechen (Rechenschaftspflicht) gegenüber Institutionen, Bürgern und ihren Gemeinschaften.

Vertiefung der Konzepte und Ansätze zur Wirkung. Für diejenigen, die sich eingehender und aus alternativen und ergänzenden Perspektiven mit Methoden der Wirkungsmessung und des Wirkungsmanagements befassen möchten, empfehlen wir:

1. BetterEvaluation, eine Wissensplattform und globale Gemeinschaft, die sich der Verbesserung und Verbreitung von Methoden und Instrumenten für eine gute Bewertung von Projekten, Interventionen und öffentlichen Maßnahmen widmet. Sie bietet insbesondere ein Tool(RainbowFramework), mit dem Sie Ihr eigenes Bewertungssystem besser definieren und verwalten können, eine Auswahl spezieller Leitfäden und eine ausführliche Beschreibung (mit Beispielen und einer umfassenden Übersicht über weiterführende Links) der in der Welt der Bewertung verwendeten Methoden und Ansätze;

2. Das von der Europäischen Kommission (GD INTPA) erstellte Evaluierungshandbuch. Es konzentriert sich speziell auf Evaluierungsverfahren und -prozesse, die bei europäischen Projekten in Drittländern zum Einsatz kommen, enthält aber auch wertvolle Hinweise darauf, wie der Evaluierungsprozess von der Definition der Interventionslogik (drittes Kapitel über Ansätze, Methoden und Instrumente) an gesteuert werden kann;

3. DasIPSEE (Inventory of Problems, Solutions and Evidence on Effects), eine spezielle Plattform, die vonASVAPP, der Vereinigung für die Entwicklung der Evaluierung und Analyse der öffentlichen Politik, unterhalten wird. Sie bietet einen Überblick über die Probleme, die von der öffentlichen Politik angegangen werden sollten, die gewählten Lösungen und die vorhandenen empirischen Nachweise über ihre Auswirkungen, begleitet von einem Glossar über die Auswirkungen und einem Überblick über die verwendeten Methoden;

4. Eineausführliche Überprüfung von Leitfäden und Tools, die von spezialisierten Organisationen im Bereich Impact Investing erstellt wurden, denen wir einen eigenen Abschnitt gewidmet haben.Impact Investing zeichnet sich durch eine methodische und bewusste Mobilisierung von Ressourcen aus, um eine messbare Wirkung in Bereichen zu erzielen, in denen es daran mangelt (Grundsätze der Intentionalität, Messbarkeit und Zusätzlichkeit);

5. Ein Leitfaden, der im Rahmen von CIVITAS entwickelt wurde, einer Initiative der Europäischen Union, die sich der urbanen Mobilität widmet. Obwohl er Beispiele für den spezifischen Sektor enthält, bietet er eine sehr klare, umfassende und allgemeine Behandlung des Themas der Projekt- und Programmbewertung.

6. Ein benutzerfreundliches Handbuch für die Projektevaluierung, das in den USA (Regierungsbehörde National Science Foundation) entwickelt wurde und einen systematischen, umfassenden und wissenschaftlichen Ansatz für das Thema Projektevaluierung bietet.